Showcase

コスト最適化と高速分析を両立

Snowflake・BigQueryで実現するデータドリブン経営

Before

- IDシステム・ECサイト・基幹システム(SAP)などに顧客データが点在し、事業間で横断的に活用できていなかった

- CDPの運用を続ける中で、コスト最適化や柔軟で高速なデータ連携・分析の仕組みが求められていた

- 事業部ごとに顧客データがサイロ化され、顧客理解が断片的でパーソナライズ施策が難しかった

After

- 基幹システム系データはSnowflake、Webサイトの行動履歴データはBigQueryへの移行により、運用コストを大幅に削減

- DWH・データマート中心のアーキテクチャでデータ連携を自動化し、分析から施策実行までのリードタイムを短縮

- 統合された顧客データを活用し、BI・MAツールで迅速な現状分析とパーソナライズ施策を実現

アプローチ

きっかけは、出版系実績管理システムのEOLでした。

スクラッチ開発された出版系実績管理システムをEOLまでに開発コストを抑えて移行するための選択肢はBIツール(Qlik)。基幹システムから連携されるデータを統合する新しいデータ活用基盤を構築すれば、他のデータ活用もそちらに統合できる。

そのためにはCDP(カスタマーデータプラットフォーム)を中心としたこれまでの運用をモダンデータスタックを活用したデータ活用基盤に早急に移行する必要性が出てきました。

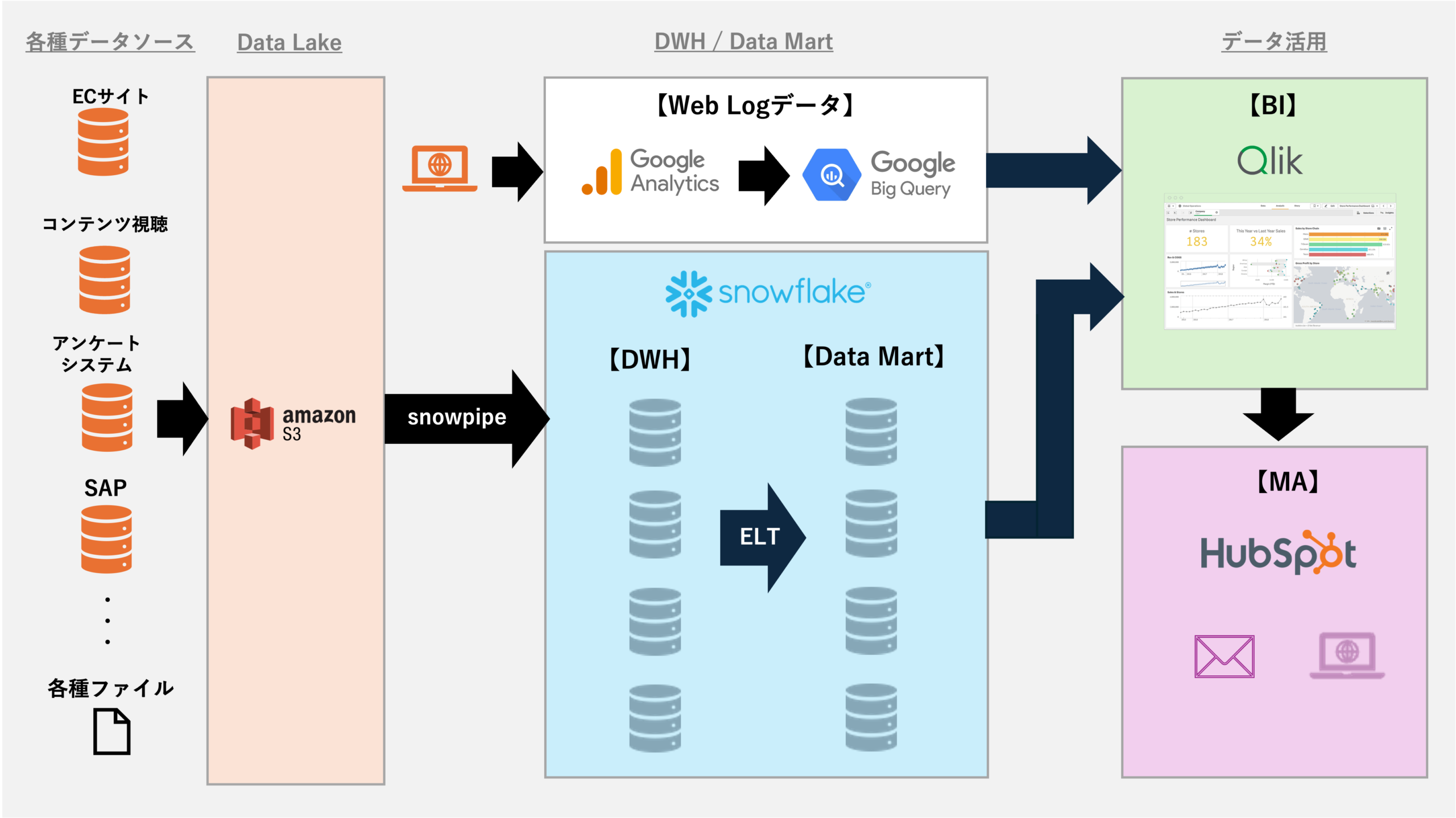

ERPであるSAPデータやビジネス単位で導入されている様々なデータをデータレイク(Amazon S3)に連携させて、DWH・データマートであるSnowflakeに統合します。

また、Webサイトの行動ログはGoogle BigQueryに蓄積し、Snowflakeと併せて、スケーラブルな新データ基盤への移行が完了しました。

新基盤ではデータ連携を自動化し、BIツール、MAツール(HubSpot)にも日次連携されますが、BIツールからはセグメント化された顧客データをMAツールに連携し、パーソナライズしたメール送信も自動化しています。

手作業ゼロで日次分析を実現

MA活用で顧客ごとに最適なコミュニケーションへ

Before

- ECサイトの購買データとサイト上の行動履歴が分断され、顧客一人ひとりに合わせた最適なコミュニケーションができなかった

- 各種分析や週次ミーティング用レポートの作成に、多くの手作業工数がかかっていた

- データ活用が遅れ、マーケティング施策や改善アクションが後手に回っていた

After

- 週次ミーティングのレポート作成工数をゼロに削減し、分析業務を効率化

- 日次ベースでの実績把握とBIツールによる深掘り分析が可能となり、データに基づいた迅速な意思決定を実現

- MAツールと連携し、メルマガ自動送信・購買履歴に基づくセグメンテーション・カゴ落ちや視聴履歴に応じたクーポン発行など、マーケティング活動の自動化・高度化を実現

アプローチ

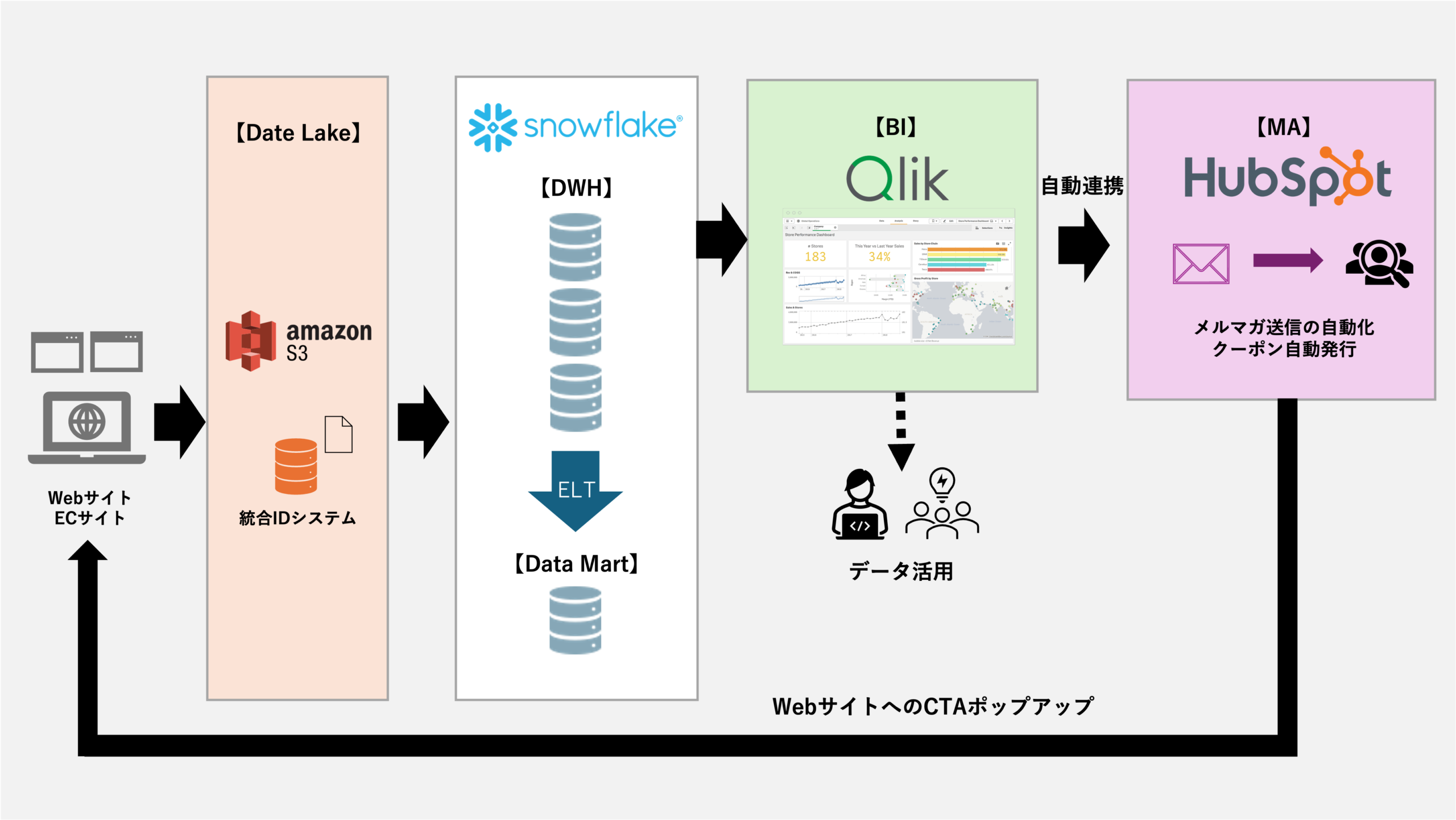

従来はECサイトのデータや基幹システム(SAP)のデータをダウンロードして、週次の報告のためにExcelで人手で集計を行うという運用でした。このような運用では、報告のためのデータ集計に膨大な工数を費やす必要があるだけでなく、結果がわかってもその原因まで掘り下げることは困難で、タイムリーな施策実行はできません。

そこで各種データをデータレイク(Amazon S3)に連携し、DWHから日次で自動集計された数値をBIツール(Qlik)で確認できるようにしました。毎日最新のデータが集計されるだけでなく、BIツールで原因まで深堀りできるようになり、ビジネスサイクルは大幅に高速化されました。

また、これまでメールシステムに手動で投入して顧客にメール送信していましたが、MAツール(HubSpot)を導入し、データが自動連携されるようにしたことで、施策の即時実行が可能になりました。例えば会員登録後に自動的にステップメールが送信されるだけでなく、契約の更新時期やレコメンドが必要なタイミングでメールが自動送信されます。

また無料特典利用者やカゴ落ちがあった顧客には、定期的にクーポンメールが送信されるなど、データドリブン文化が定着し、ビジネススタイルは、より戦略的に変革していきました。

MAツール導入の成否は、その裏にあるデータ活用基盤にあることを実証する典型例であると考えます。

膨大なGoogle Analyticsデータを分析起点で最適化

基幹システム統合で、KPI把握・原因追及でアクションを迅速化

Before

- 基幹システムとGoogle Analyticsのログデータが結びついていない

- 基幹システムで結果は集計されているが、分析するにはダウンロードしてExcel集計が必要

- コンバージョンした顧客の傾向が掴みきれていない

- データに基づいたクライアントのフォローが行えていない

After

- Webサイト行動履歴と基幹システムのデータを統合して、顧客の動向をあらゆる視点から分析できるようになった

- ビジネス上の販売機会ロスを計数化することで、事業の改善に役立った

- 主要KPIを迅速かつ正確に把握でき、予実管理の精度が向上した

- クライアントへのフォローにデータを活用することで、クライアントからの信頼が向上した

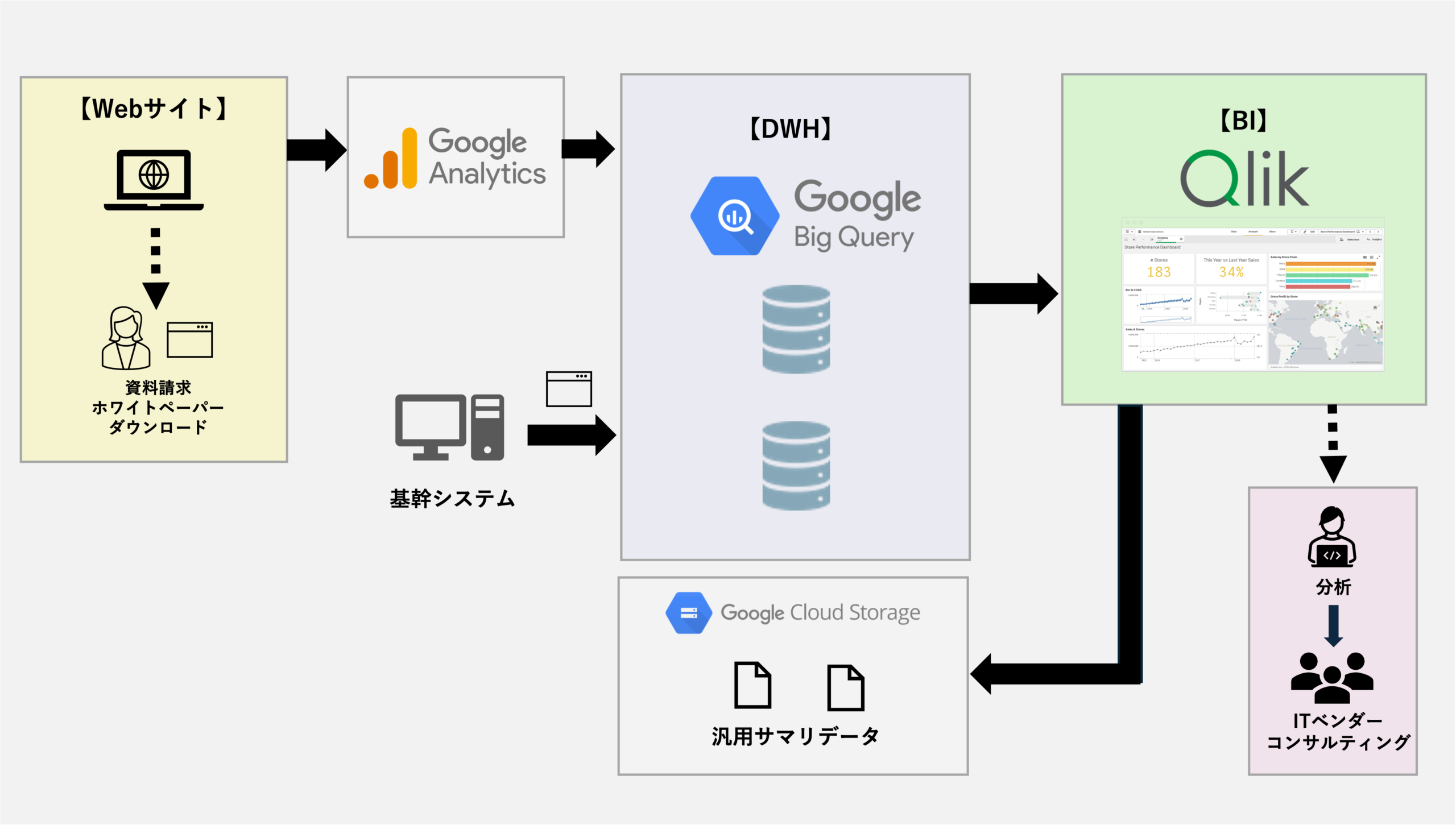

アプローチ

このユーザ様では、基幹システム、Webサイト行動履歴、Excelデータが散在する中、DWH、データマート等の基盤構築に長期で取り組んでいました。

現場からはデータ分析に対する要求が強く、これらのデータベース側の構築が完了を待つことなく、データの視覚化を行えないかという相談から約4ヵ月でデータ分析基盤を完成させました。

Google BigQueryに蓄積される月間1000万超のWebサイトのログを、データ活用側の視点で集計・加工し、BIで無理なく集計できるサイズに圧縮しました。

必要なデータは明細のまま、それ以外は日次あるいは月次の集計済みデータとしてBI側に取り込み、BI側は日次のデータロード時しかBigQueryに対するクエリを実行しないため、運用コストを大幅に削減できます。

BIのダッシュボードでは、Webサイトのログデータは基幹システムのデータとコンバージョンベースで結合されており、横断的な分析が可能な他、Excelで管理されている月次計画値データを加重平均で日次計画値化しており、日次ベースで予実管理できるよう工夫されています。

日々の計数管理のみならず、分析視点を切り替えたり、分析を深堀りすることで、データドリブン文化の醸成に貢献しています。

基幹システムとKintoneの統合、そしてMA連携まで

案件と応募人材のマッチングのプロセスをMAで可視化・自動化

Before

- 人材の採用までのプロセスはkintone、稼働後は基幹システムで管理しており、データが結びついていない

- エリア担当制を取っており、営業担当毎に情報格差が成約率の差になっている

- Kintoneに人材データが埋もれており、案件に最適な人材を提供できないままロストするケースがある

- 架電タイミングを逃すと、応募者と連絡が取れなくなることがあり、使えない人材情報が増える傾向にある

After

- エリア担当制から業務プロセス担当制へ改革を行い、責任体制を明確化

- 応募〜成約・不成約までのプロセスでどこでどれだけの離脱が発生しているかを計数管理できるようになった

- 選考プロセスでのコミュニケーションを適切なタイミングでEメール、LINEで自動化できた

- 選考プロセスの差分データから履歴データを生成し、過去と現状を比較して傾向がつかめるようになった

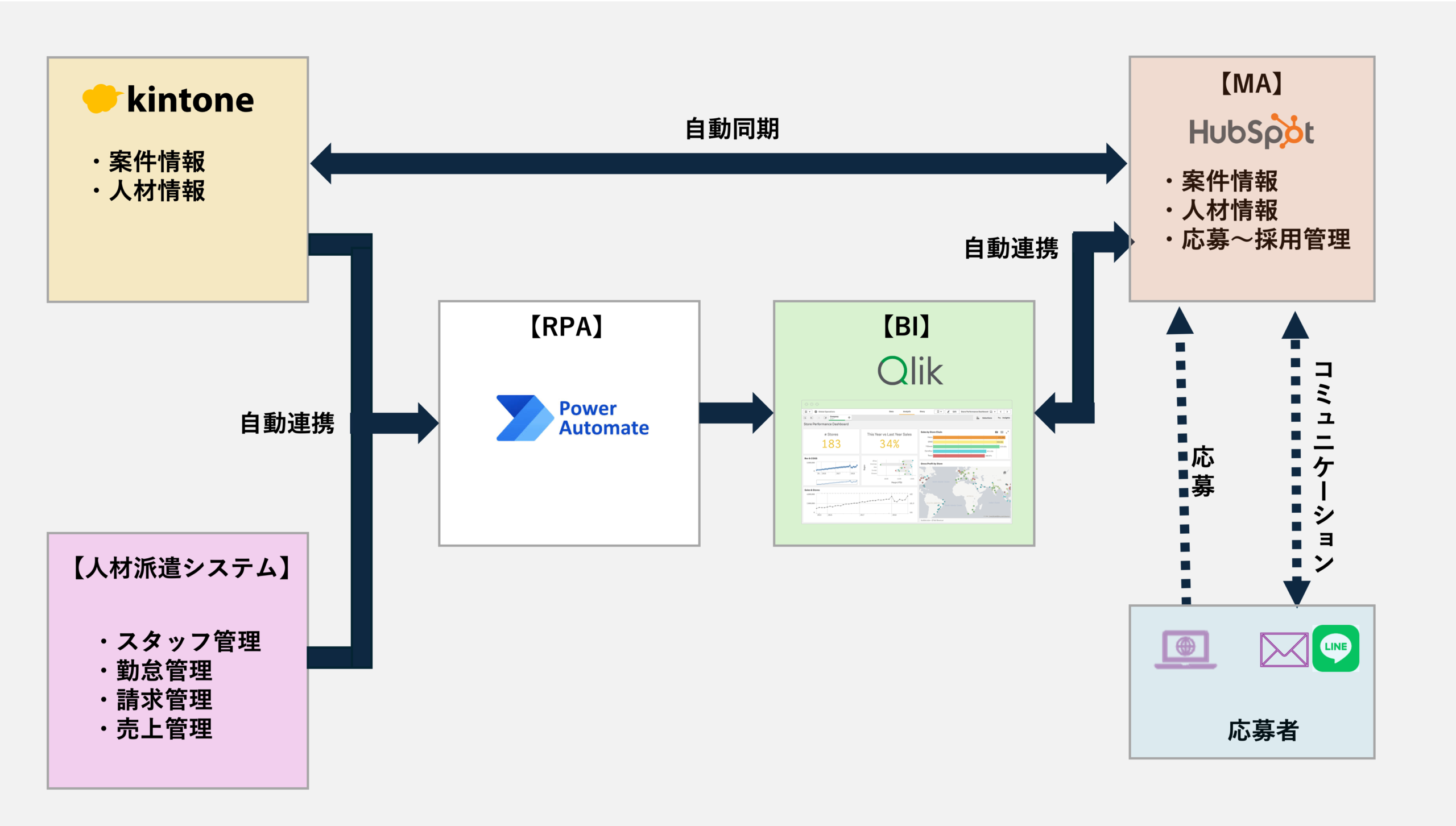

アプローチ

Kintoneで作成した採用管理は作成者が既に退職しており、メンテナンス不可能な状態になっていました。

Kintoneではこれ以上の拡張は困難と考え、以下の方針で基盤を整理することにしました。

- Kintoneと基幹システムはBIツール(Qlik)に統合し、ID管理する

- 基幹システムはDB接続が許可されていないため、Power Automateでファイル出力

- MAツールとしてHubSpotを採用し、業務の流れに沿ったプロセスをパイプライン化

- 過渡期としてKintone-HubSpotは自動的に同期させる

- 顧客との接点はHubSpotでEメール自動化を図り、LINE連携によりコミュニケーションの強化も実施

データベースとの直接接続やAPI連携ができないようなケースが発生した場合、RPAツールを割り切って使うのも選択肢でしょう。

このユーザ様ではPower Automateで、基幹システムやKintoneのデータをファイル出力し、BIにデータ連携をしています。

またBI側からHubSpotへはQlik Automate(ワークフローツール)で連携を行い、ローコードで自動連携を実現しました。

Qlik側では、基幹システム・Kintone・HubSpotを統合したデータで分析する基盤を構築し、各種の計数管理、案件マッチングのしくみを実現しています。

HubSpotでは人材の応募時点からデータを取得し、業務プロセスに沿った社外コミュニケーションや関係者への自動通知なども実現し、大幅なアクションの最適化が可能になりました。